西瓜书学习

参考网址

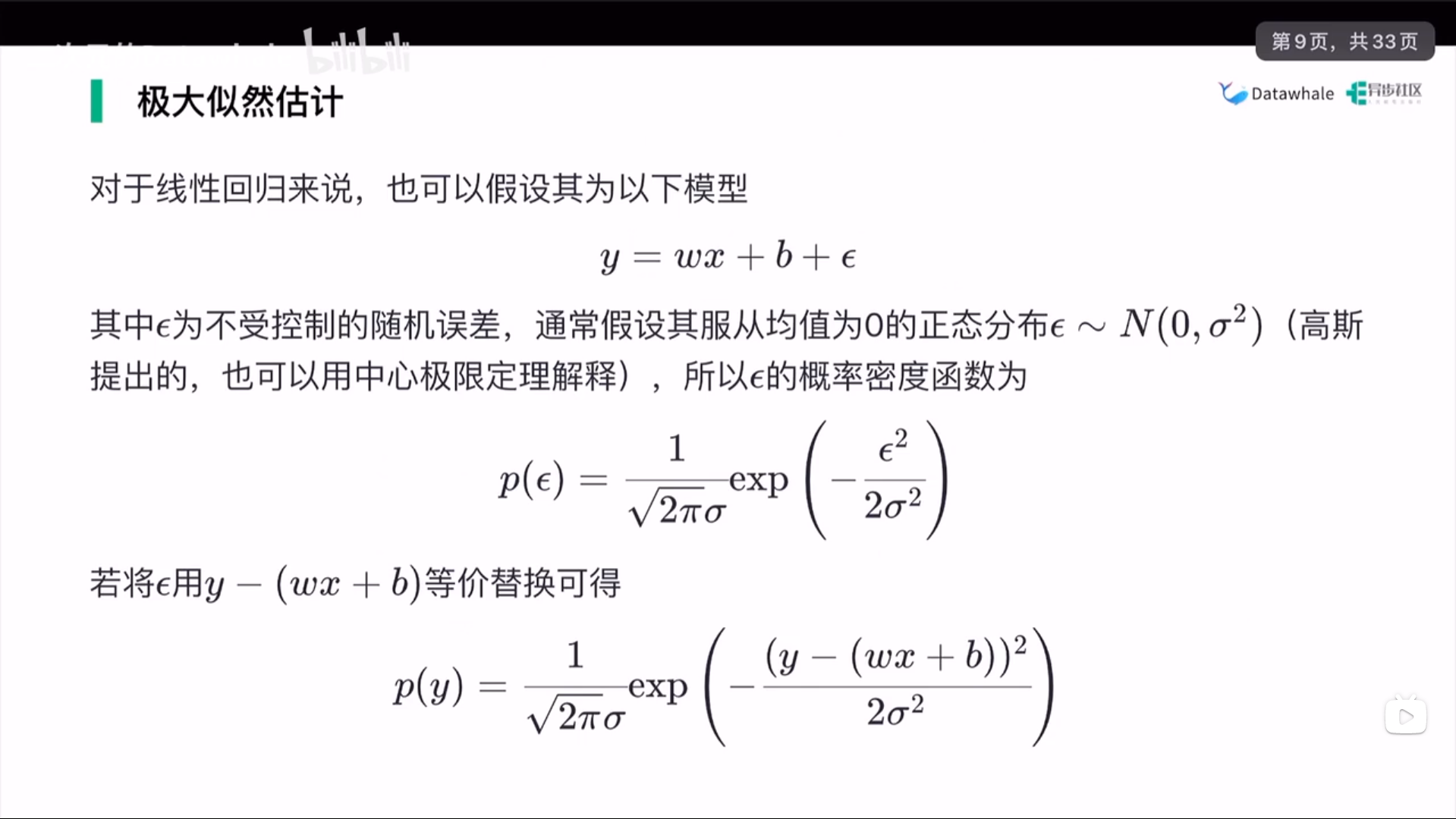

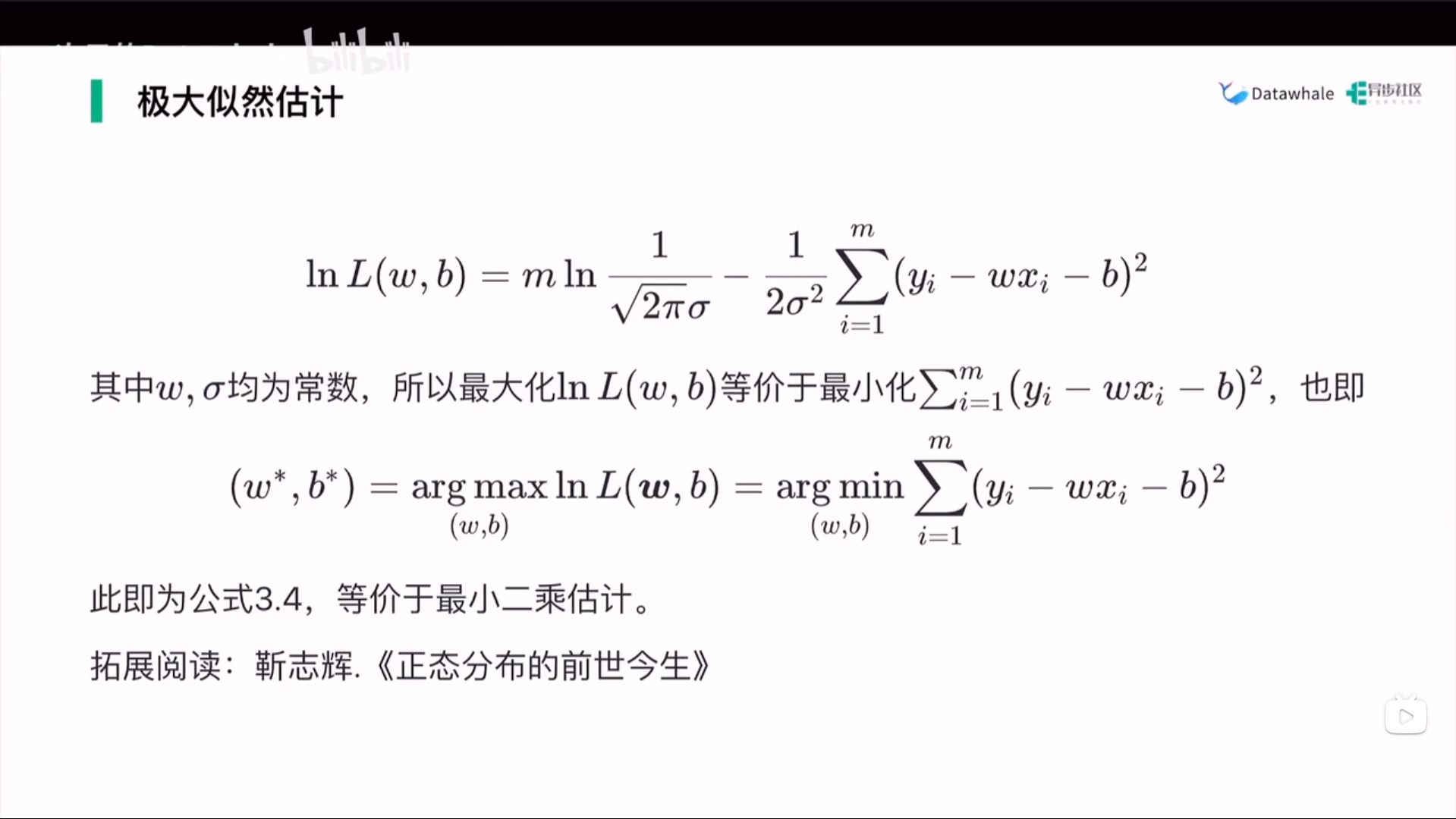

一元线性回归

1 | 算法原理 |

1 | 线性回归损失函数: E(w, b) = Σ(yi - f(xi))^2 |

例题

1 | 样本符合正态分布 X ~ N(u, sigma^2) |

机器学习三要素

1 | 模型: 根据具体问题, 确定假设空间 |

多元线性回归

1 | 由最小二乘求解损失函数Ew |

对数几率

1 | 算法原理 |

信息论概念

相对熵(描述两个分布的差异)

1 | 最小化相对熵的方式达到最接近模拟分布, 最小化型对上等价于最小化交叉熵 |

决策树

1 | 算法原理 |

原理

1 | 从逻辑角度一堆的if else语句组合 |

ID3决策树

1 | 通过信息熵来表现其样本纯度,主要思路是,由于条件越来越多,对于它的描述越来越清晰,也就越来越纯,也就是信息熵最小 |

C4.5对ID3的优化

1 | 使用ID3时采样样本太少,取值数目过多,会导致过拟合 |

CART

1 | 基尼值越小, 遇到异类的概率越小, 纯度越高 |

神经网络

1 | M-P神经元 |

感知机

1 | y = sgn(wTx + b) |

神经网络

1 | 本质是通过多层y=f(x)网络, 拟合任意线性不可分数据集 |

支持向量机

1 | 算法原理 |

软间隔与支持向量机回归

1 | 算法原理 |

贝叶斯分类器

1 | 贝叶斯决策论 |

集成学习

1 | 个体与集成 |

本博客所有文章除特别声明外,均采用 CC BY-NC-SA 4.0 许可协议。转载请注明来自 某飞行员的随笔!