每日学习问答笔记

每日学习笔记

222-11-3

1 | Q: 关于slam重定位的讨论 |

1 | 问题起因: 当厂家给我们传感器误差时的意思实际上就是说他们的传感器可以近似拟合高斯分布 |

2022-11-4

1 | Q:关于长走廊与隧道问题 |

1 | Q: 关于法向量的思考 |

1 | Q: 对于scantomap中map的理解 |

1 | Q: 简述说明icp过程? |

1 | Q1: 简述ndt过程? |

1 | Q: 思考GPS,反光板,二维码与land_mark在图优化中的作用 |

1 | Q: 思考图优化中滑窗与边缘化 |

2022-11-5

1 | Q: 关于重定位与slam关系思考 |

1 | Q: 多线程数据传输 |

2022-11-9

1 | Q1: 在做最小二乘时,error做损失函数的目的是? |

2022-11-10

1 | Q: 对于vector等STL与智能指针来讲,对于内存消耗与运行速度思考 |

2022-11-11

1 | Q1: 在进行QR稀疏矩阵求解或者Cholesky分解前由于矩阵为稠密矩阵,消耗非常大怎么办? |

1 | Q: Chou_Liu Tree理解?(可以理解为将稠密矩阵转化为稀疏矩阵的一种方式) |

2022-11-16

1 | Q: 对于map更新思考 |

1 | Q: 关于二维地图修正 |

1 | Q: 关于Eigen库稀疏矩阵使用 |

2022-11-17

1 | Q1: 关于单层神经网络流程理解 |

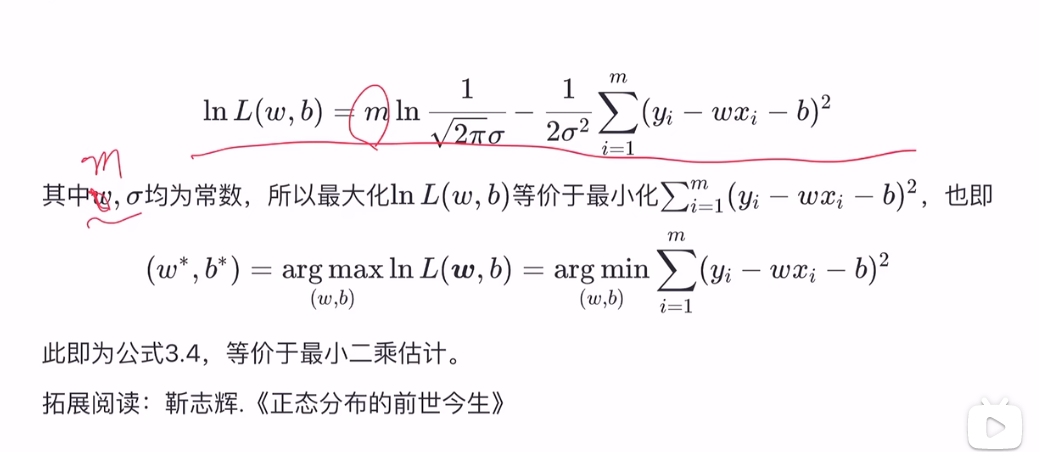

1 | Q: 数值最小二乘与最大似然估计相关性 |

1 | Q: 对数几率回归应用 |

本博客所有文章除特别声明外,均采用 CC BY-NC-SA 4.0 许可协议。转载请注明来自 某飞行员的随笔!